Ontosight® – Biweekly NewsletterJune 17th – June 30th, 2024 –Read More

Ontosight® – Biweekly NewsletterJune 17th – June 30th, 2024 –Read More

May 24

Apr 24

Innoplexus wins Horizon Interactive Gold Award for Curia App

Read MoreFrankfurt „Daten, überall Daten, aber keine Medikamente“, so klagte einst Jerry Karabelas, der frühere Pharmachef des Schweizer Konzerns Novartis. Damals, um die Jahrhundertwende, hatte sich die Pharmabranche gerade mehr oder weniger vergeblich durch die Datenflut aus der gerade boomenden Genomics-Industrie gewühlt. Es folgte eine lange Phase der Ernüchterung.

Knapp zwei Jahrzehnte später hat ein neuer Datenrausch die Arzneimittelindustrie erfasst. Und dieses Mal, so sind Branchenvertreter überzeugt, könnte er einen nachhaltigeren Effekt entfalten. Vas Narisimhan, Karebelas’ Nach-Nachfolger und inzwischen Chef von Novartis, spricht von einer „digitalen Revolution“ und sieht den Schweizer Pharmariesen mitten im Wandel zum „Medizin- und Datenwissenschafts-Unternehmen“. Der Baseler Konkurrent Roche investiert unterdessen Milliarden in spezialisierte Daten- und Analysefirmen wie die US-Firma Foundation Medicine und will „die Achse Pharma- Diagnostika durch eine dritte Achse, das Datenmanagement, ergänzen“, wie es Roche-Chef Severin Schwan formuliert. Tina Lupberger, Strategie- und Innovationschefin in der Onkologiesparte des US- Konzerns Pfizer spricht bereits von einem Paradigmenwechsel für die Pharmaindustrie. „ Wenn wir uns nicht bewegen, werden es andere tun“, warnt sie. Und Big Pharma werde in die Zulieferer-Rolle gedrängt.

Bislang gilt die Branche meist als Nachzügler in Sachen Digitalisierung. Aber inzwischen hat der Aufholprozess begonnen. Das Thema steht daher nicht nur bei Pfizer, Roche und Novartis, dem Führungstrio der Pharmabranche, ganz weit oben auf der Agenda. Das finanzielle Potenzial ist nach Schätzung von externen Fachleuten erheblich. Experten von McKinsey etwa sprechen von einer „100-Milliarden-Dollar-Gelegenheit“ für den Pharmasektor.

Sie schätzen, dass fortgeschrittene Datenanalyse der Branche in den nächsten zehn Jahren zwischen 45 und 75 Prozent Ebitda-Steigerung bringen könnte. Branchenfachleute von EY gehen davon aus, dass künftig vor allem digitale Plattformen maßgeblich über den Erfolg von Pharmaunternehmen entscheiden werden.

Anders als in den späten 90er Jahren, als sich die Euphorie fast ausschließlich auf die Gendaten konzentrierte, berührt das Thema Big Data die Arzneimittelriesen heute auf weitaus breiterer Front. Im Prinzip wird das gesamte Geschäftsmodell davon beeinflusst.

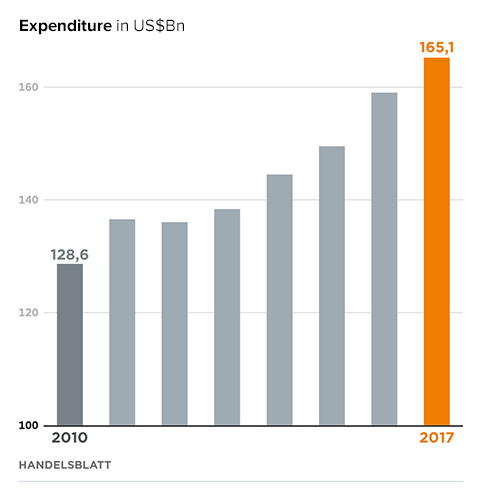

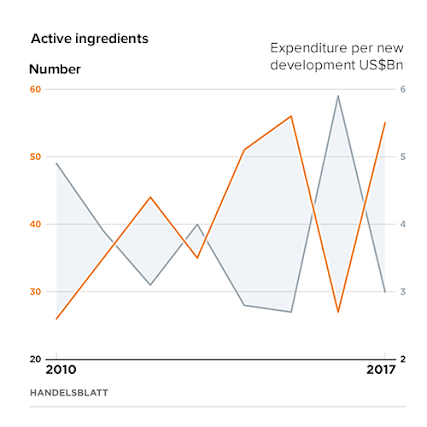

Den kommerziell wertvollsten Beitrag, so die Hoffnung vieler Branchenvertreter, könnte Big Data aber vor allem in der Produktentwicklung leisten. Denn sie gilt in finanzieller Hinsicht

weiterhin als gewisser Schwachpunkt für die Branche. Zwar hat die Zahl der erfolgreichen Neuentwicklungen zuletzt wieder deutlich zugenommen.

Die Zusatzumsätze reichen im Schnitt aber nicht, um das Wachstum zu beschleunigen und ordentliche Renditen auf die Forschungsinvestitionen zu verdienen. Eine Analyse von McKinsey zeigt, dass in den 1990ern die Umsätze von neu entwickelten Medikamenten in den ersten sieben Jahren nach Markteinführung dreimal so hoch waren wie die Kosten für ihre Neuentwicklung.

Grafik: Pharmaindustrie

Grafik: Pharmaindustrie

Aktuell liegt der Faktor bei 1,1, das heißt, dass die Umsätze nur noch geringfügig höher als die Kosten sind. Der sogenannte „Return on Investment“ der Pharmaforschung ist also rückläufig. Big Data, so die Hoffnung, könnte einen entscheidenden Hebel bieten, diesen Trend wieder umzukehren.

Die Ansätze sind dabei vielfältig und werden sowohl von den Pharmafirmen intern als auch von externen Spezialisten vorangetrieben. Erhebliche Effizienzgewinne könnte etwa künstliche Intelligenz für diverse Routinetätigkeiten in der Forschung bringen. Werner Seiz, Forschungsdirektor bei Sanofi-Aventis Deutschland, verweist auf die riesige Zahl von

Gewebeproben, die im Zusammenhang mit der Prüfung von Wirkstoffen auf möglicherweise

krebserregende Wirkung analysiert werden müssen.

Um das auszuschließen, müssen Pharmafirmen Zehntausende von Gewebeproben von ihren Pathologen prüfen lassen. Moderne Bilderkennungssysteme können diese Arbeit beschleunigen und verbessern.

JOHNSON & JOHNSON FORSCHUNGSCHEF STOFFELS

Ein Riesenthema sind darüber hinaus der bessere Zugang zum vorhandenen Wissen und dessen effizientere Nutzung mithilfe neuer Such- und Analysesysteme. Der

Pharmakonzern Abbvie baut gerade eine eigene Datenbank der Wissenschaftsliteratur auf, aus der sich die Forscher ähnlich wie beim Musikstreamingdienst Spotify ihre eigenen Fachliteraturkollektionen anzeigen lassen können. „Wir wollen mit diesem Angebot eine neue Interaktion in Gang setzen. Beispielsweise zwischen verschiedenen Disziplinen, wenn Neurologen und Onkologen an demselben Protein forschen, sich darüber bisher aber noch nie ausgetauscht haben.

Oder dass man Forschern an anderen Standorten des Unternehmens folgen und deren Literaturauswahl teilen kann. Der entscheidende Vorteil wird sein, dass wir Forscher enger zusammenbringen“, sagt Lars Greiffenberg, zuständig für die IT im Bereich Forschung und Entwicklung sowie „Translational Informatics“ bei Abbvie Deutschland.

Dass es heute überhaupt Mitarbeiter mit solchen Funktionsbezeichnungen in der Pharmaindustrie gibt, zeigt schon den Wandel der Branche. Translational Informatics soll helfen, Brücken zwischen früher und später Forschung, externen und internen Wissenschaftlern zu schlagen, um mehr Austausch zwischen den verschiedenen Gruppen zu ermöglichen. So sollen schneller und effizienter neue Wirkstoffe entwickelt werden können.

Greiffenbergs Einschätzung nach wird es aber noch ein paar Jahre dauern, bis das „Spotify der Fachliteratur“ bei Abbvie so weit trainiert ist, dass man tatsächlich von künstlicher Intelligenz sprechen kann.

Der Computer werde dem Wissenschaftler dann Literatur, die ihn interessiert, vorschlagen, „weil die Maschine seine Interessengebiete und Vorlieben kennt und weil sie es schafft, aus den täglich 8.000 bis 10.000 neuen wissenschaftlichen Veröffentlichungen die für ihn relevanten herauszufiltern“, sagt der promovierte Biologe.

Abbvie hat übrigens schon jetzt vom Aufbau der eigenen Datenbank profitiert: Bei der Literaturanalyse wurden zahlreiche zusätzliche Proteine gefunden, die an der Entstehung von Alzheimer beteiligt sein könnten. Diese sind bisher in keiner der kommerziellen Datenbanken, auf die die Pharmaindustrie zurückgreifen kann, aufgetaucht.

„Ob und inwieweit diese Proteine eine Rolle spielen, muss natürlich jetzt weiter erforscht werden. Aber wir schlagen ein neues Forschungskapital auf, weil wir die Literatur anders erfasst haben“, sagt Greiffenberg.

Einen etwas anderen Weg ging der Pharmahersteller Merck, der ein ähnliches System in Kooperation mit der Eschborner Analytikfirma Innoplexus aufbaut. Auch hier war es das Ziel, interne und externe Daten den eigenen Wissenschaftlern schneller, einfacher und effizienter zugänglich zu machen und mithilfe künstlicher Intelligenz die Nutzung dieser Daten quasi auf ein neues Niveau zu heben.

Merck will das System intern nutzen, aber auch extern zugänglich machen. Es ist daher nicht in der Pharmasparte angesiedelt, sondern in der Life-Science-Sparte des Konzerns, die ohnehin bereits als einer der führenden Zulieferer für die biopharmazeutische Forschung agiert. „In der Forschung haben wir bisher noch zu wenig von dieser Art Data-Sharing“, sagt Merck-Chef Stefan Oschmann. Man sehe daher riesiges Potenzial in dem Projekt.

Die 2011 gegründete und mittlerweile rund 250 Mitarbeiter starke Innoplexus versteht sich als Spezialistin, die mithilfe strukturierter Datenpools und künstlicher Intelligenz unter anderem Finanzdienstleistern und Pharmafirmen sowohl die nötige Software als auch öffentlich verfügbare Informationen zugänglich machen kann. „Unser Ziel ist die

Demokratisierung von Daten und das Aufbrechen von Datensilos innerhalb eines Unternehmens sowie zwischen Organisationen“, sagt Innoplexus-Mitgründer Gunjan Bhardwaj.

Die Software des Unternehmens kann nach eigenen Angaben unter anderem genutzt werden, um mehr als 27 Millionen Fachpublikationen, eine Million Dissertationen und 375.000 klinische Studien zu analysieren. Insbesondere die präklinische Forschung, glaubt der Innoplexus-Chef, könne durch solche Systeme deutlich beschleunigt werden.

Ähnliche Ziele, aber von einer anderen Ausgangsbasis aus, verfolgt die börsennotierte US- Firma Medidata. Sie ist auf Software für klinische Studien spezialisiert, erzielt als führender Anbieter auf dem Gebiet bereits rund 600 Millionen Dollar Umsatz und bringt fast fünf Milliarden Dollar Börsenwert auf die Waage.

Mit den Systemen des Unternehmens arbeiten nach eigenen Angaben 18 der 25 führenden Pharmakonzerne sowie zahlreiche kleinere Arzneimittelhersteller, Biotechfirmen und Clinical Research Organisationen (CROs).

Strategisches Ziel ist es nun, das Software- und Serviceangebot zu verbreitern und aus der aggregierten Analyse der Studiendaten neue Erkenntnisse und Lösungen für die Branche zu generieren. „Die Pharmabranche liegt zum Teil noch weit zurück in der Adoption von neuen Technologien auf dem Gebiet“, glaubt Medidata-CEO Tarek Sherif.

„Das bietet große Möglichkeiten für uns.“ Schon in einigen Jahren, zeigt er sich überzeugt, könnte das Unternehmen auf eine Milliarde Dollar wachsen. Das Langfristziel ist es, eine Art SAP der Life-Science-Industrie zu werden.

Ähnlich wie Big Pharma und viele Konkurrenten schaut das US-Unternehmen dabei inzwischen ebenfalls über die Daten hinaus, die direkt in der Forschung und den klinischen Studien generiert werden. Auch Daten aus der klinischen Praxis rücken zusehends ins Blickfeld sowohl der externen Dienstleister als auch der Pharmakonzerne selbst.

Denn auch diese Informationen werden zunehmend in einer Form erhoben, die eine großflächige Analyse mithilfe künstlicher Intelligenz möglich machen. Zudem sind immer mehr Gesundheitsdaten verfügbar, die über die Informationen aus der klassischen Diagnostik hinausreichen.

Vor allem zwei Faktoren treiben diese Entwicklung an. Die immer leistungsfähigeren molekularbiologischen Diagnostikmethoden, insbesondere im Bereich der Gensequenzierung, und wachsende Möglichkeiten, mithilfe von Konsumelektronik (etwa Smartphones und Wearables) Gesundheitsdaten kontinuierlich zu erfassen.

Boehringer-Chef Hubertus von Baumbach sieht in den Möglichkeiten sogar den nachhaltigsten Effekt der Digitalisierung. Vor allem diese Datenflut werde künftig die Profile der Medikamente bestimmen.

In eine ähnliche Richtung zielt Roche mit dem vor wenigen Monaten vereinbarten Kauf der US-Firma Flatiron für 1,9 Milliarden Dollar. Flatiron ist auf Softwarelösungen für die elektronische Aufbereitung und Auswertung von klinischen Daten im Bereich der Krebstherapie spezialisiert und hat in Zusammenarbeit mit diversen US-Kliniken eine umfassende Datenbank mit den Behandlungsdaten von Patienten aufgebaut.

Die will Roche nun nutzen, um das vorhandene Wissen mit „Real-World-Daten“ anzureichern.

Das bietet aus Sicht von Roche-CEO Schwan nicht nur die Möglichkeit, Medikamente präziser einzusetzen, sondern könnte auch Rückschlüsse über bisher ungekannte Wirkmechanismen von Arzneien bringen. „Man sieht Zusammenhänge, die man vorher gar nicht sehen konnte.“

Flankiert wird die Übernahme von Flatiron durch Allianzen mit dem Beratungsunternehmen Accenture und der Healthcare-Sparte des US-Konzerns General Electric (GE). Accenture soll Hilfe geben bei der Datenintegration, GE Know-how beisteuern im Bereich der bildgebenden Diagnostik. Bereits vor drei Jahren sicherte sich der Baseler Konzern für mehr als eine Milliarde Dollar eine Mehrheit am US-Unternehmen Foundation Medi‧cine, das auf die digitale Analyse von Genomdaten spezialisiert ist. Diese will Roche nun mit den Datensätzen von Flatiron koppeln, um in der Krebsbehandlung noch tiefere Einblicke in das Zusammenspiel von genetischen Faktoren und Arzneitherapien zu generieren. Gerade bei den sehr heterogenen Krebserkrankungen, glaubt Schwan, könnte sich das als wichtiger Vorteil herausstellen.

Allerdings steht und fällt der Nutzen der softwaregestützten oder gar selbstlernenden Datenauswertung mit der Qualität der Daten. „Künstliche Intelligenz wird nur dann ihre Stärken ausspielen können, wenn die Frage, die diesem Prozess zugrunde liegt, sehr präzise formuliert wurde“, sagte Greiffenberg von Abbvie. „KI braucht gute Vorbereitung. Einen Mähroboter können Sie auch nur sinnvoll einsetzen, wenn der Rasen entsprechend vorbereitet wurde.“

MERCK-CHEF STEFAN OSCHMANN

Viele Pharmaunternehmen sind mittlerweile in Initiativen wie IMI, Allotrope und Pistoia engagiert, die dazu beitragen, dass etwa Forschungsdaten so aufbereitet werden, dass sie unternehmensübergreifend genutzt werden können. Dass sie etwa maschinenlesbar sind und wieder auffindbar. Das klingt einfach, ist aber mit einem immensen Aufwand verbunden. Solche Initiativen sind nach Ansicht von Greiffenberg sehr wichtig, um die Stärken von künstlicher Intelligenz in der Branche eines Tages auch ausspielen zu können. Etwa indem die Unternehmen Zugriff auf die nötige Zahl an klinischen Daten bekommt, um die Algorithmen zu trainieren, damit später verlässliche Analysen gemacht werden können. „Für eine Firma allein ist es zu kostspielig, einen ausreichenden Datenpool aufzubauen“, sagt der Abbvie-Direktor.

Das Firmenwissen, das geistige Eigentum, geben die Firmen bei solchen Kooperationen übrigens nicht auf. Man muss sich das so vorstellen, dass sie ihren Algorithmus quasi zum Training in die anderen Firmen geben – und besser ausgebildet zurückbekommen. „Die Studiendaten der einzelnen Firmen bleiben geschützt“, sagt Greiffenberg.

Dieser Artikel wurde ursprünglich auf handelsblatt veröffentlicht.

Frankfurt, Germany, 3rd June 2024, 9am CET Partex, a leading provider of AI-driven solutions in the pharmaceutical industry, is thrilled to…

Frankfurt, Germany, 23 April 2024 – Partex, a leading provider of AI-driven solutions in the pharmaceutical industry, is thrilled to…

Frankfurt, Germany; 28 March 2024 – Partex Group, a pioneer in AI-driven drug discovery, announces a collaboration with Althea DRF…

During the German Cancer Congress 2024 in Berlin, the companies Innoplexus AG /Amrit AG, companies of Partex N.V., presented the…

Frankfurt, Germany; 14 March 2024 Partex Group, a pioneer in AI-driven drug discovery, today announces a collaboration with global pharmaceutical…

January 02, 2024 – Innoplexus and Amrit AG, members of the Partex NV Group, providers of innovative technology for health…

Exciting News! Anavex Life Sciences and Partex NV Announce Strategic Partnership to Enhance Patient Experience. Anavex Life Sciences Corp. and Partex NV N.V. Group are pleased to announce…

The treatment and support of patients with advanced tumor diseases is a complex task involving numerous disciplines. For the interdisciplinary…

Artificial Intelligence (AI) pioneer Innoplexus and London based Parametric Insurance start-up, Innovatrix Capital, collaborating upon using AI & Machine Learning…

Innoplexus and Inflection Biosciences enter strategic collaboration based on Artificial Intelligence to expedite PIM kinase inhibitor development ESCHBORN, Germany, May 30,…